简单3步,提升谷歌商店A/B测试准确性

A / B 测试十分常见,对于 ASO 也同样适用。

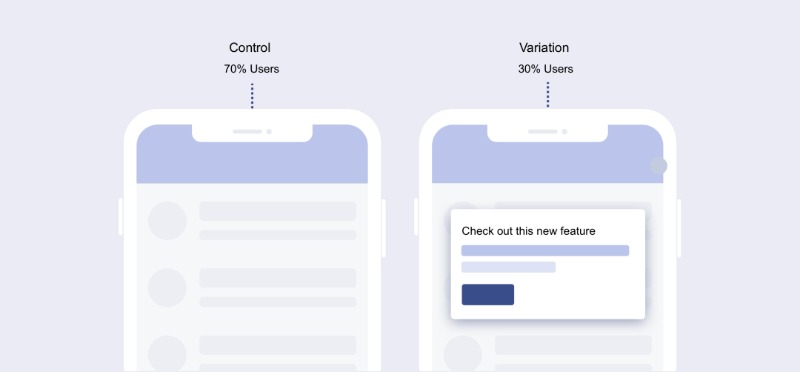

其原理也很简单:将用户分为多个样本,向他们展示不同的变量(例如:不同的元数据截图),并衡量每个变量的表现方式,以便根据数据决定使用哪个变量。

然而在测试中,开发者通常会面临这个问题:单次测试结果缺乏代表性。

尽管 Google Play 能在本地环境下运行 A / B 测试,并得出提升转化的结果,但是往往将其运用到所有受众后,却得不到预期的结果。

这种情况我们称之为 “假阳性”,原因是 Google Play 的统计在一定程度上存在缺陷。那要如何避免 “假阳性”,提高 A / B 测试的准确性呢?

因为 Google 的 A / B 测试工具无法区分用户,所以在构建测试样本过程中可能会出现误差。

举个例子,对你的 APP 认知度很高的用户,在搜索品牌词再到下载的过程,所花费时间非常短。

而通过广告导流,或搜索行业词、竞品词的用户,将花费更多时间停留在展示页,以确认 APP 元数据信息是否合心水。

但在 Google Play 进行 A / B 测试时,后台并不会对不同流量来源的用户进行过滤。如果不对用户进行区分,那么在做 A / B 测试验证不同变量的时候,你可能会得到不同的样本,从而导致了结果差异。

另一个需要屏蔽的 “噪音” —— 季节性 (即特殊的节日、节点)对应用商店下载的影响。

在做谷歌实验时,最重要的一点就是学习 A / B 测试背后的基本统计模型。

A / B 测试时需要衡量多方要素:A、B 结果间是否存在足够大的差异;是否检测到真正的差异 (假阴性);实际上不存在的差异 (假阳性)等。

而谷歌实验中,并没有提供清晰的数据来证明不同测试结果,结果取决与每个样本的大小,较大的样本会有助于发现 “假阳性”。对此有几点开发者需要注意:

第一,确保测试周期在 7 天以上。这不仅能减低季节性导致的误导结果的风险,还能让引入足够的样本。

第二,不需要在节日节点、运营活动期间回避测试,反而应确保在整个测试期间每个渠道之间流量分配的稳定。

第三,在测试中创建两个相同的 B 变体 (即 A / B / B 测试) 提升结果准确性:如果两个 B 样本均导向相似的结果,则可能是真结果,反之则可能是 “假阳性”。

A / B / B 测试中最常见的方法是控制流量。

三个样本的流量分配比例 33.34% :33.33% :33.33%,并且不得在测试中添加 C 变量。

第一个 B 样本预测变化幅度为 + 0.3% 至 + 4.8%,而第二个 B 样本预测变化幅度为 - 2.4% 至 + 2.5%。

如果两个 B 样本的结果截然不同,那么 A / B / B 测试可以标记为可疑结果,两个结果中至少有一个是假阳性。

最后,开发者还可以通过以下维度,对结果进行记录:

1、应用名称

2、应用类别

3、测试的商店清单(全球 / zh-cn 默认 / en-uk / es-spain / …)

4、开始和结束日期

6、应用流量分配

7、每个版本的安装程序

8、置信区间下限

9、置信区间的上限

10、已经应用的测试变体,测试后一周和之前一周之间转化率的差异

相信一次次的迭代,我们能够利用 A / B 测试得到更高的转化率。

* 本文图片来源网络

- 1. 新上线的App该如何做ASO优化 | 开发者必看六大法则 新上线的App该如何做ASO优化 | 开发者必看六大法则

- 2. 小米商店5大免费推广玩法,雷军的一往无前真的很OK 小米商店5大免费推广玩法,雷军的一往无前真的很OK

- 3. 出海APP必备谷歌应用商店ASO指南 出海APP必备谷歌应用商店ASO指南

- 4. 新上架App如何获得App Store青睐:弄清权重那些事 新上架App如何获得App Store青睐:弄清权重那些事

- 5. 【干货】少花钱多带量,一帖搞定安卓6大应用市场关键词覆盖! 【干货】少花钱多带量,一帖搞定安卓6大应用市场关键词覆盖!